小澤 仁(おざわ・ひとし)

バンコック銀行執行副頭取。1977年東海銀行入行。2003年より現職。米国在住10年。バンコク在住26年。趣味:クラシック歌唱、サックス・フルート演奏。

バンコック銀行執行副頭取。1977年東海銀行入行。2003年より現職。米国在住10年。バンコク在住26年。趣味:クラシック歌唱、サックス・フルート演奏。

パソコンや携帯電話で数多く使われる半導体。しかし半導体の仕組みを本当にわかっている人はあまり多くない。この半導体がここ数年で急速な進化を遂げている。そしてその進化を支えているのが米国のNVIDIA(エヌビディア)社である。残念ながら日本ではこのNVIDIAの半導体技術を体系的に説明したものがない。今回、このNVIDIAの技術上の強みを、できるだけわかりやすく日本語で説明することを試みた。今回のレポートでは、まだまだ専門用語が多く使われている。しかしNVIDIAの技術の解明と一般化が行われなければ、日本の半導体技術は世界レベルからいよいよ後れを取ってしまう。読み進むのにちょっと苦労するかもしれないが、ぜひご一読いただきたい。2回に分けて紹介する。

1 半導体の概要

1-1 半導体の定義・仕組み

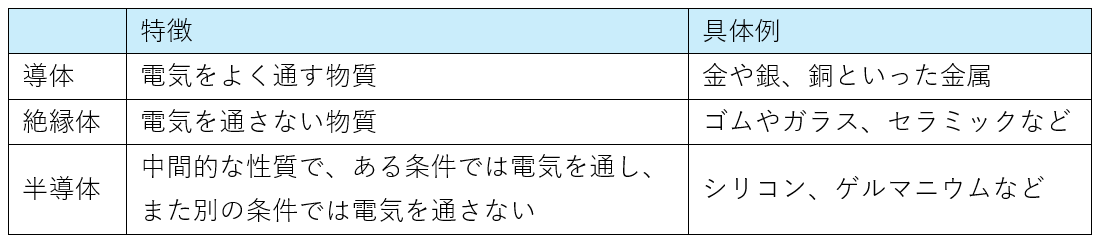

半導体とは、電気をよく通す導体と電気を通さない絶縁体との中間の性質を持った物質。その特徴をうまく活用することによって、電流を制御することができる。

表1 導体、絶縁体との比較

(出典)半導体に関する書籍より筆者作成

電気の流れやすさは、原子構造上、自由に動ける電子数で決まる。銅などの導体は自由電子数が多く、一方、ゴムなどの絶縁体は自由電子数が少ない(ほとんど無い)。

半導体の特質は、その中間にあたる物質として「不純物を添加することで、絶縁体から導体に近い状態に変化すること」。例えば、半導体によく使われるシリコンは、単体では安定した状態のため、電気を通さない。しかし、リンなどの不純物を添加することで、自由電子が存在するようになり、そして電圧を加えることで電気が流れる。

この半導体の「電圧の変化によって、電流を制御できる」スイッチ機能を活用して、電気信号のオンとオフの状態を2進数の「0」と「1」に対応させるデジタル回路を作ることができ、「0」と「1」の情報を電子の有無で記憶することができる。

この原理を使った基本的な製品がトランジスタ。これまで何十年もの間微細化を進めた結果、最先端の半導体では何百億個というトランジスタが使われている。スマートフォンにも100億個以上のトランジスタが使われ、高速な演算や通信などを実現している。

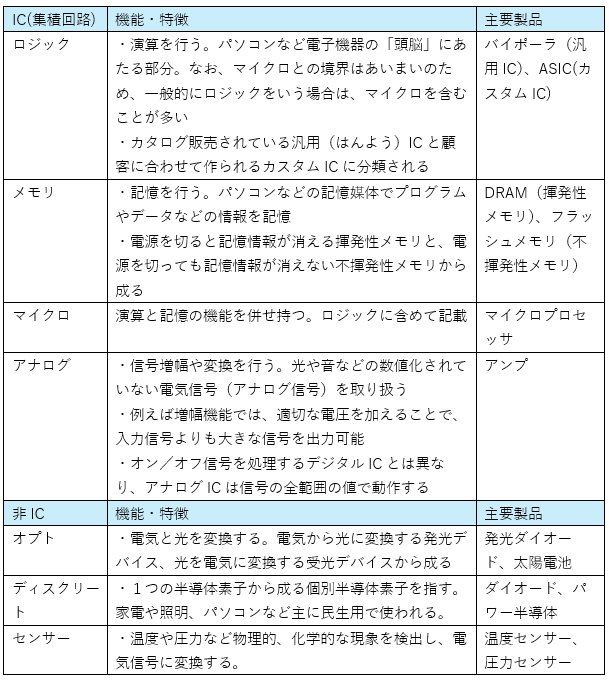

1-2 電子部品(以下、半導体と表記)の分類

世間一般で言われる半導体とは、シリコンなどの半導体材料で作られた電子部品の総称を指す。この電子部品は様々な種類があるが、世界の主要半導体メーカーが加盟するWSTC(世界半導体市場統計)の基準では、IC(集積回路)と非ICに分けられる。

表2 半導体の分類(WSTC基準)

(出典)WSTCのウェブサイトを基に筆者作成

①IC(Integrated Circuit)とは、トランジスタやダイオード、コンデンサーなど数多くの回路素子を搭載した電子部品のこと。集積度を高めたものをLSI(大規模集積回路)ということもあるが、ICと同じ意味で使われている。

②近年、電気自動車の普及などに伴い電力制御などに使われるパワー半導体の需要が増加している。パワー半導体は非ICのディスクリート(個別半導体素子)であり、ロジックなどのICとは構造や使われる技術などが全く異なる。

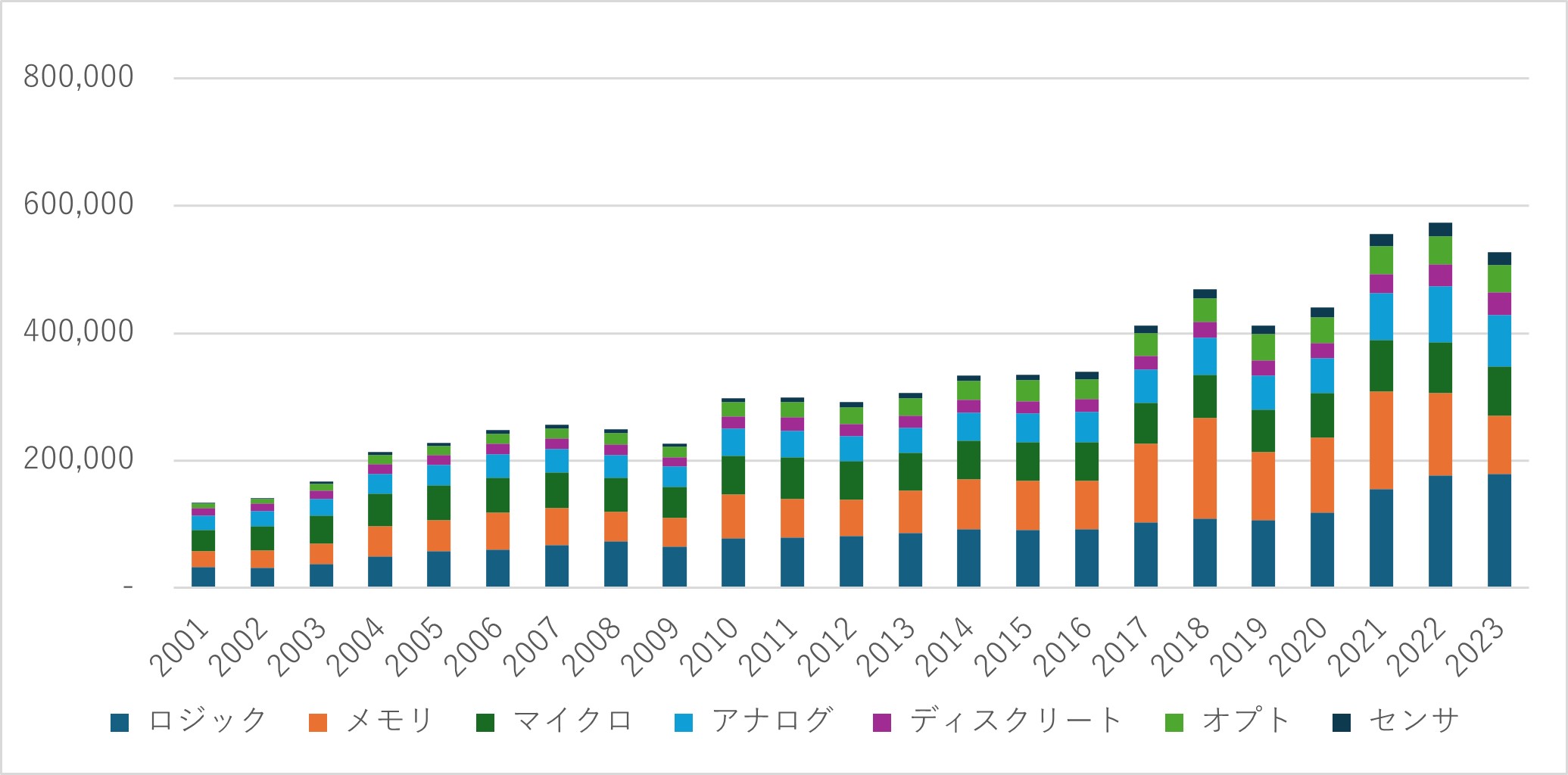

1-3 半導体の市場動向

図1 半導体市場の長期時系列推移(製品種類別)

(出典)WSTCより筆者作成

図2 半導体市場の用途内訳(2021年)

(出典)Semiconductor Industry Association「2022 FACT BOOK」より筆者作成

①半導体市場は、2023年時点で5269億ドルと2001年から2023年にかけて約4倍に成長。パソコンや携帯電話(スマートフォン含む)の普及や自動車・産業分野への半導体搭載範囲拡大、データセンター向けサーバ市場拡大などが成長要因。

②製品別ではICが8割を占める。特に演算機能を使うロジック半導体が3割を占め、2001年から2023年にかけて5倍以上に成長。続いてメモリが2割弱を占める。このように、ロジックとメモリで約半分を占めている。

③用途別では、パソコンやタブレットなどのPC/コンピューター、スマートフォンやデータセンターなどの通信関係で合計6割超を占める。これらには、ロジックやメモリ、マイコンなどが幅広く使われている。パソコンやスマートフォンの出荷台数は落ち着きつつあるものの、5Gなどの高速通信需要拡大など高機能化により、1台あたりの半導体素子数は増加傾向にある。

1-4 主要半導体メーカー

表3 2023年半導体売上上位20社(単位:百万ドル、ファウンドリは除く)

(出典)英調査会社Omidia発表内容を基に筆者作成

①国別で見ると、上位20社中11社がアメリカ企業で、以下欧州3社、日本3社、韓国2社、台湾1社と続く。アメリカは、IntelやTexas Instrumentsなど半導体発明当初から続くIDMやAMDやQualcommなど後発のファブレスメーカーなど、ロジック、メモリ、アナログなどの企業を幅広く抱えている。その他、韓国はメモリ、欧州は車載半導体が強い。

②日本は、1992年には上位10位に6社が入っていたが、2023年時点では上位10位には1社もなく、16位のルネサスエレクトロニクスが最上位。微細化進展による技術難易度の高まり、必要投資額の増大などの外部環境変化に対し、開発から製造まで自前主義にこだわった結果、設計支援ツールや先端製造プロセスなど優れた外部技術などへのアクセスが遅れたこと、総花主義(多様な製品)や家電メーカーの一部門であったことで、投資効率や開発スピードで劣ったことなどから、シェアを失った。

③メーカー別で見ると、2位のNVIDIAの躍進が目立つ。前年比233%と他社と比べ圧倒的な売上の伸びを見せる。当社は生成AIの発展に伴い急速に伸びるGPU市場で8割以上の独占に近いシェアを持っており、2024年6月18日には、時価総額で世界首位となった。

このレポートでは、なぜNVIDIAがここまで強さを見せるのかについて、AIと半導体の関係性や、GPUを取り巻く外部環境などにも触れながら明らかにしたい。

2 AIと半導体

NVIDIAの躍進には、AI(人工知能)の急速な技術発展と半導体の性能向上が関わっている。この章では、AIの進歩と半導体との関係性について説明する。

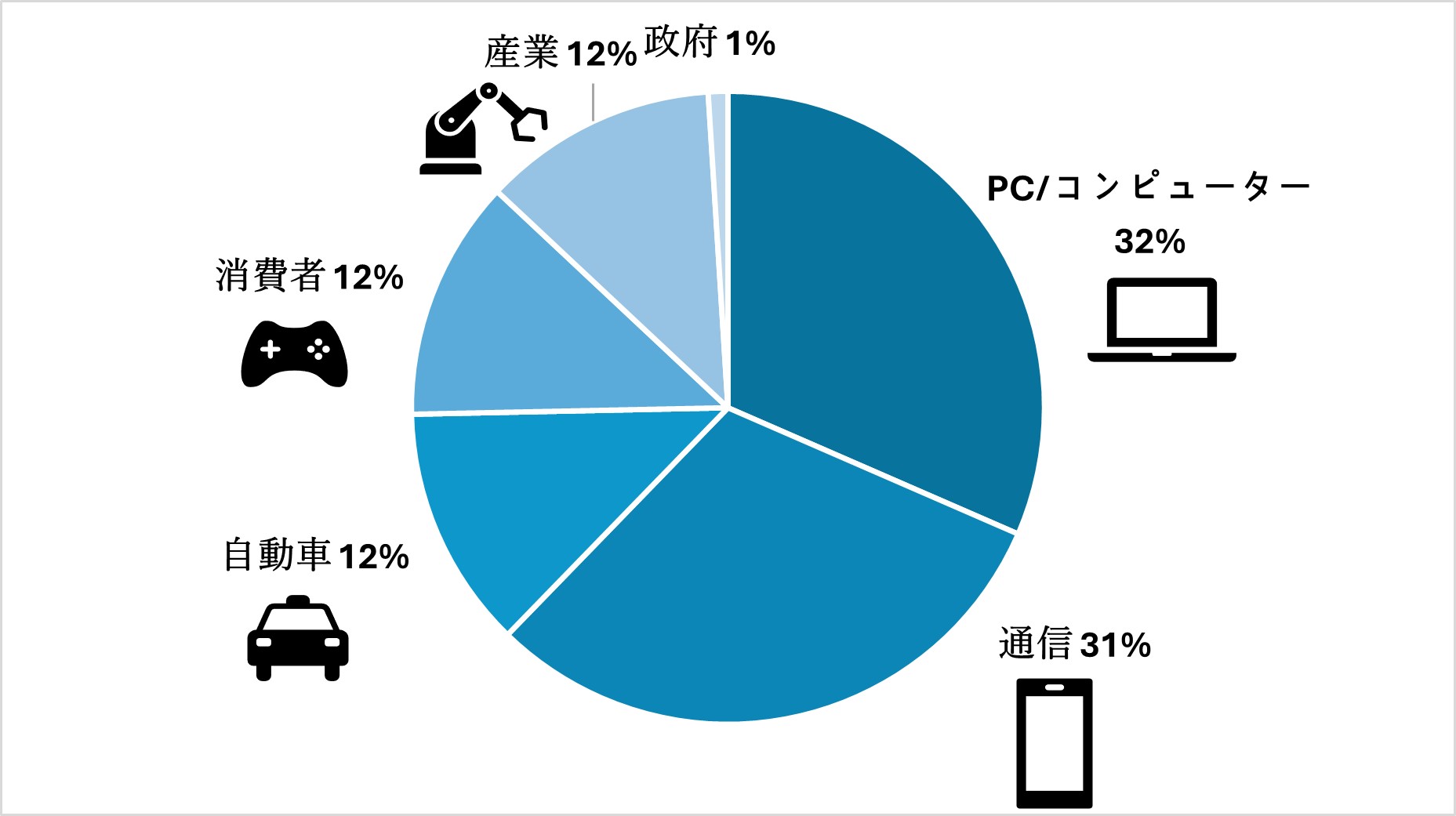

2-1 AIとは

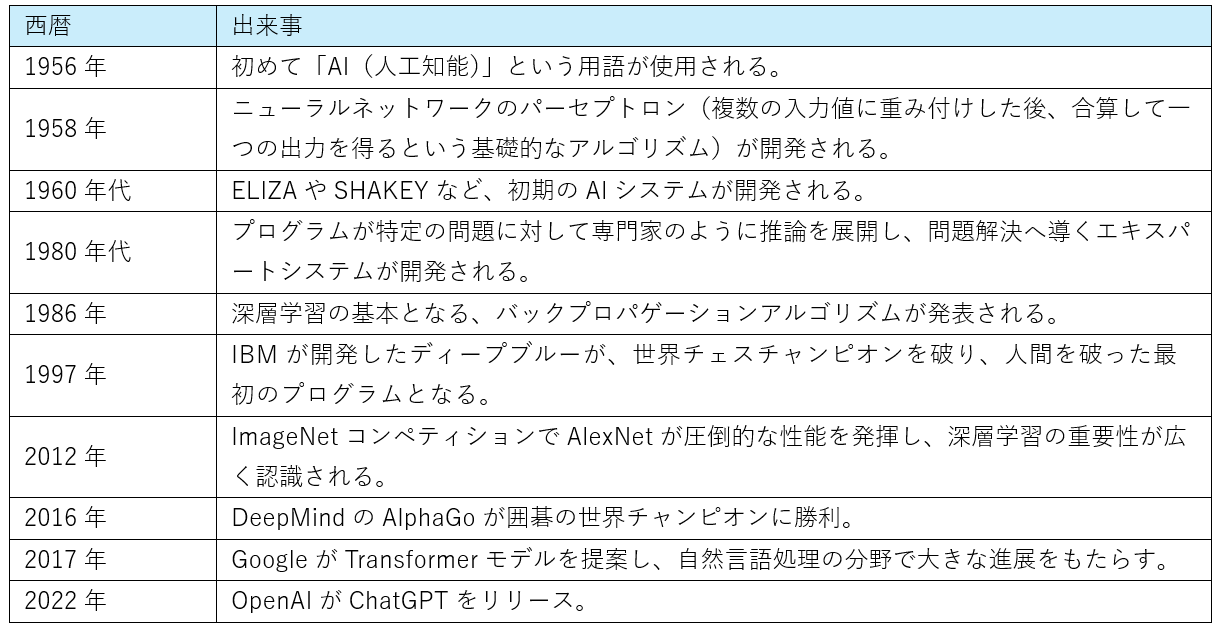

AIとは、「Artificial Intelligence」の略。明確な定義はないが、人間と同様の知能を実現しようとする取り組みやその技術を指す。これまで3回のブームがあり、1950年代~1960年代の第1次AIブーム、1980年代ごろの第2次AIブームでは、現在の機械学習や深層学習の基礎となるニューラルネットワークやバックプロパゲーション(誤差逆伝播〈でんぱ〉法)などの理論が発表されるなど、進展はあったものの、コンピューターによる計算や記憶等性能の制約から、ブームが終わりを迎えたとされている。

図3 AIの概念

表4 AIの歴史

(出典)図3、表4ともにAIに関する各種ウェブサイトより筆者作成

①2000年代から現在まで続くのが、第3次AIブーム。ここでは、インターネットやスマートフォンの普及などによるデータ流通量の増大、GPUなど半導体の性能向上を背景に、「機械学習」が実用化された。機械学習以前のAIでは、判断するルールを人間が決める必要があったが、機械学習では、AI自身が膨大なデータを学習することで、ルールやパターンを自ら探し出す。例えば、果物の画像認識を行う場合、色や形などどの特徴に着目すれば識別できるかを自ら定義付けることができる。その結果、例えばバナナでは「黄色のものが多いが、緑色のものも存在する」などの認識も可能となる。

②更に2012年に、世界的な画像認識技術の精度を競うコンテストであるImageNetでトロント大学(カナダ)のチームがより複雑なモデルである深層学習を利用し、圧倒的な性能を発揮。ここに、NVIDIAのGPUが使われている。それ以降、深層学習が広く使われるようになった。深層学習では、人間の脳の神経回路を模して数理モデル化したニューラルネットワークを利用。

③2017年には、Googleが自然言語処理向けの深層学習モデル「Transfomer」を発表。これを基にOpenAIの「GPT」などのLLM(大規模言語モデル)が開発され、2022年のChatGPTの発表につながった。

2-2 深層学習と半導体の関係性

深層学習に必要な膨大な演算を短時間で実現するために、半導体が重要な役割を果たしている。

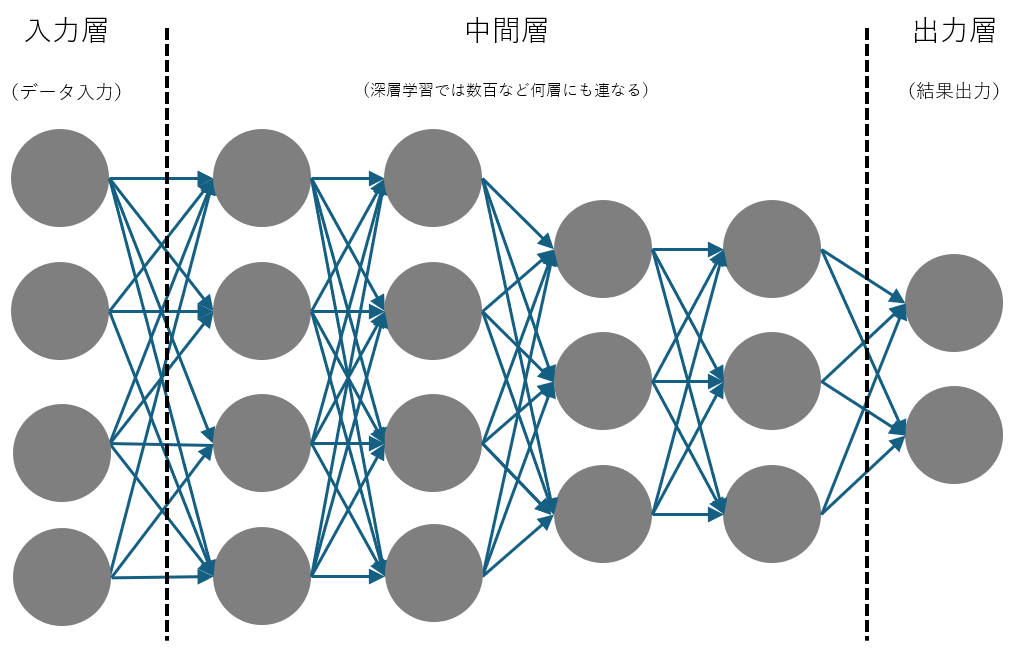

図4 ニューラルネットワークの構造

(出典)AIに関する各種ウェブサイトより筆者作成

人間の脳では、100億から1000億個程度存在するとされる神経回路のニューロン(神経細胞)がシナプスを介してつながり、情報を伝達。その情報の伝わりやすさは、接合部であるシナプスの結合強度で変わる。つながっている別のニューロン(数万に上る場合もある)から電気信号を受けた場合、その信号の総和大きさの大小で別ニューロンへの情報伝達の可否が決まる。

機械学習のニューラルネットワークでは、ニューロンが入力層・中間層・出力層の三つから成る。入力層で外部からデータを読込み、中間層でデータの特徴を学習。最後に出力層から、分析結果を出すという仕組みになっている。

このデータの特徴を学習するためには、中間層の各項目でランダムに設定された「重み」や「バイアス値」の値を各項目行列計算によって調整する必要があり、深層学習では何百もの中間層を持つこともある。色や形状など基本的な特徴を抽出後、特徴の組合せによって複雑なパターンなどを抽出するため、膨大な積和演算が必要となる。

例えば、カラー画像の画像認識を例に取ると、演算を行うために全て数値データに変換する必要がある。スマートフォンカメラの標準的な画素数である1200万画素(4000ピクセル×3000ピクセル)を扱う場合、3原色(赤、緑、青)の値を掛け合わせて入力層だけで3600万ものデータ数となる。そこに各項目別に重み、バイアス値が設定される。実際の画像認識では、情報量を圧縮する様々な技術が使われているが、いずれにしても学習や推論を行うにあたっては、優れた演算機能を持つロジック半導体が数多く必要となる。

汎用ロジック半導体の主流は、CPUとGPUに分けられ、AI開発以降長らくCPUが使われてきたものの、現在のAIの深層学習にあたっては、主にGPUが使われている。

2-3 CPUとGPUの比較

CPUとGPUは共にAIに使われるが、GPUは単純な演算を高速に処理可能であるため、AIの膨大だが比較的単純な演算に向いている。

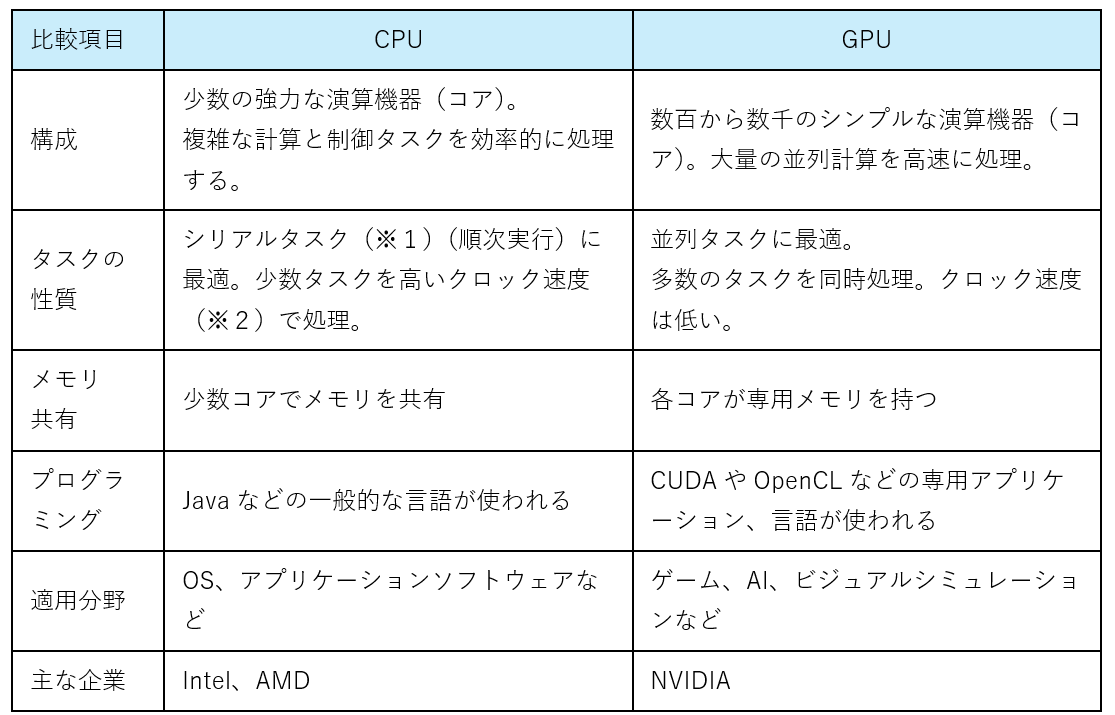

表5 CPUとGPUの比較表

(※1)シリアルタスク:タスクを順番に一つずつ処理する方法。タスク間に依存関係がある場合に適す。

(※2)クロック速度:コンピューターが一秒間に行えるクロックサイクルの数。クロックサイクルとは命令の取得から実行までの基本的な操作サイクル。ヘルツ㎐で表す。

(出典)半導体に関する書籍より筆者作成

①CPU(Central Processing Unit)は、パソコンやスマホなど電子機器の「頭脳」にあたる役割で、コンピューターの5大機能(制御、入力、出力、演算、記憶)のうち、制御と演算を担う。汎用的に設計されており、コンピューター全体(OS、キーボード、メモリなど)から送られてくる複雑で様々な命令を実行できる。一方、タスクを順番に処理する必要があること、コア数も少ないため、一度にこなせる数は限定される。

②それに対し、GPU(Graphics Processing Unit)は、演算機能のみを有し、画像処理など特定用途に特化した半導体チップ。数千個のコアから成り、並列処理が可能。また、各コアが専用メモリを持つためデータの転送速度が速い。そのため、演算性能は、特定の演算に限定すると、CPUの数倍から100倍以上となる。用途として、元々動画編集など画像処理用途で開発されたが、高い演算能力を活かしてスーパーコンピューターやAIの深層学習などに利用されている。

③AI分野では並列処理による高い演算性能からGPUの利用が進んでいる。ただし、GPUの利用には専用の言語などを利用する必要がある、条件分岐などの複雑な演算には適していない点に留意が必要。2020年に世界一となった日本のスーパーコンピューター「富岳」では汎用性とユーザー利便性を高めるため、約16万個のCPUが使われているがGPUは使われていない。

2-4 GPUはどのように使われるか

2-4-1 GPUの動作原理

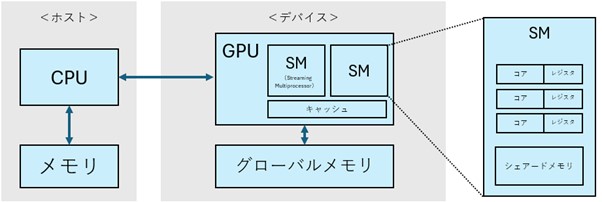

図5 GPUの動作原理

(出典)GPUに関する各種ウェブサイトより筆者作成

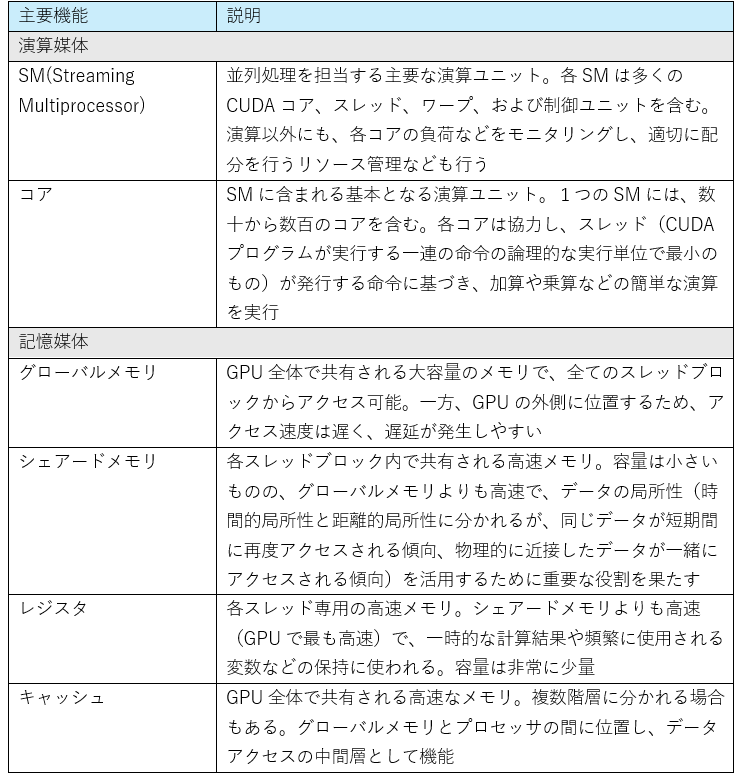

表6 NVIDIA製GPUの基本機能解説

(出典)NVIDIAウェブサイトやGPUに関する各種ウェブサイトを基に筆者作成

①GPUは、単体では動くことができないため、CPUから指示を受けて動く。NVIDIAのGPUプログラミングであるCUDA(詳細は後述)では、CPUとGPUを動かす。また、GPUが使えるメモリはCPU側のメモリとは異なっているため、GPUを動かすためには、事前にメモリの確保やデバイスへのデータ転送などを行う必要がある。

②その後、GPUを動かす段階においては、GPUの特徴をうまく活用したプログラムを組む必要がある。GPUの特徴は並列処理が可能な点だが、実行順番に依存しないタスクを各コアへ演算指示を出すことでコアの稼働率を高め、また、負荷を減らすためにコア間の通信を少なくする必要がある。

③NVIDIAのGPUプログラミングでは、処理単位が大きく三つの層(グリッド、ブロック、スレッド)に分かれている。グリッドは、CPUから実行を指示する単位でカーネル関数の全体実行を管理する。最小単位のスレッドでは、各コア単位で独立して並列に計算を実行。中間のブロックでは、SM(Streaming Multiprocessor、複数のコアなどから成る基本の演算ユニット)単位で処理を実行。スレッド別のスケジューリングやリソース管理などを行う。

④GPUの特徴は、それぞれの層にメモリがあり、データの一時保管やデータ共有などに使われる。これらの要素をどのように使えば速い演算が可能かなどを考えてプログラミングを組み、演算を実行している。GPUは、グローバルメモリと呼ばれる大容量のメモリをチップ外に持つが、各コアにて処理したデータの読み取りや結果の保存などで都度外部メモリにアクセスしていては、時間がかかり非効率。そこで、各スレッド専用のレジスタ、スレッドブロック内で共有可能なシェアードメモリ、キャッシュなどを配置し、頻繁に使うデータを予め読み込む他、処理結果の一時保存などすることで、メモリアクセスによる遅延を防いでいる。

2-4-2 浮動小数点演算

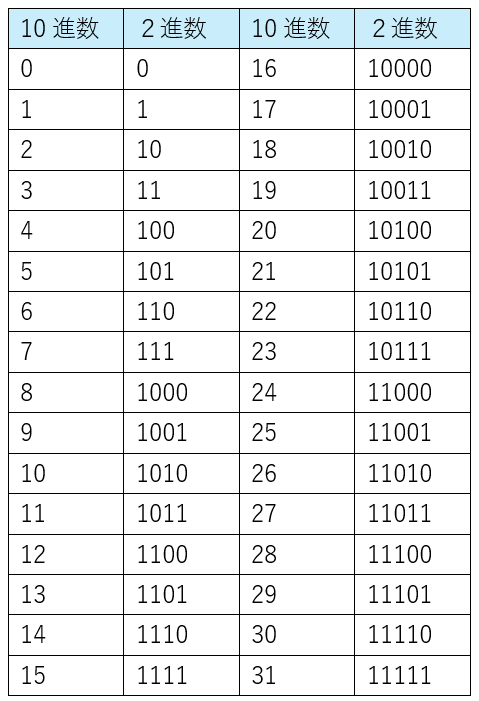

表7 2進法と10進法の違い

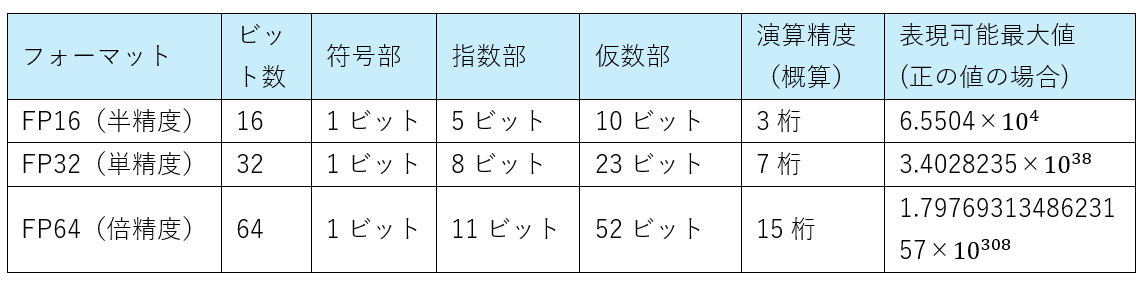

表8 浮動小数点演算の計算方法の違い

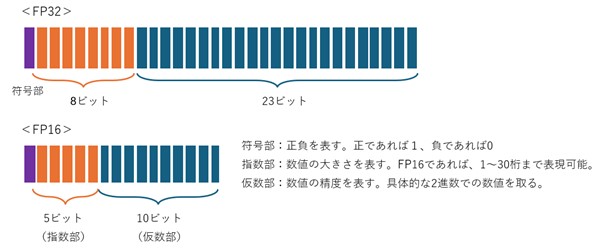

図6 浮動小数点演算のフォーマット例

(出典)表7、表8、図6ともにコンピューターに関する各種ウェブサイトより筆者作成

①コンピューターの演算では、2進法が使われる。冒頭に述べたとおり、半導体は「0・1」の切替えしかできないため、10進数に基づく演算を行う場合、2進数に変換する必要がある。ビットはコンピューターが扱う最小単位で、2進数の1桁を表す。例えば、4桁(4ビット)の場合、10進数では1万(0~9999)の値を表せるが、2進数では2の4乗である16(0~15)の値のみしか表せない。そのため、多くの桁数の演算などでは、より多くのビット数が必要となる。一般的なフォーマットとしては、16ビット、32ビット、64ビットが使われる。

②利息や確率計算など、実際の演算では、必要な桁数が非常に多くなってしまう。また、マイナスや小数点も存在するが、2進法には符号や小数点は存在しない。そこで、GPUの演算では、主に計算式の桁数を抑えるために浮動小数点演算と呼ばれる形式が使われる(整数演算も使われる)。「XXXXXXX×10n」の形式にし、乗数(指数部)で小数点の位置を決める。コンピューターで処理(演算や記憶など)するために10進数の有限桁の小数で近似値として扱う。

③FP16、FP32、FP64などの方式があり、桁数が多くなればなるほど高精度な演算が可能になる一方、演算量が増えるためスピードは低下する。例えば1.1という数値を表す場合、FP16では、浮動小数点演算「0 01111 0001100110」→10進数「約1.099609375」に対し、FP32では、浮動小数点演算「0 01111111 00011001100110011001100」→10進数「約1.0999999940395355」とより高精度に表現可能。

3 GPU市場の動向

続いて、NVIDIAが圧倒的なシェアを持つGPUの市場動向について概観する。

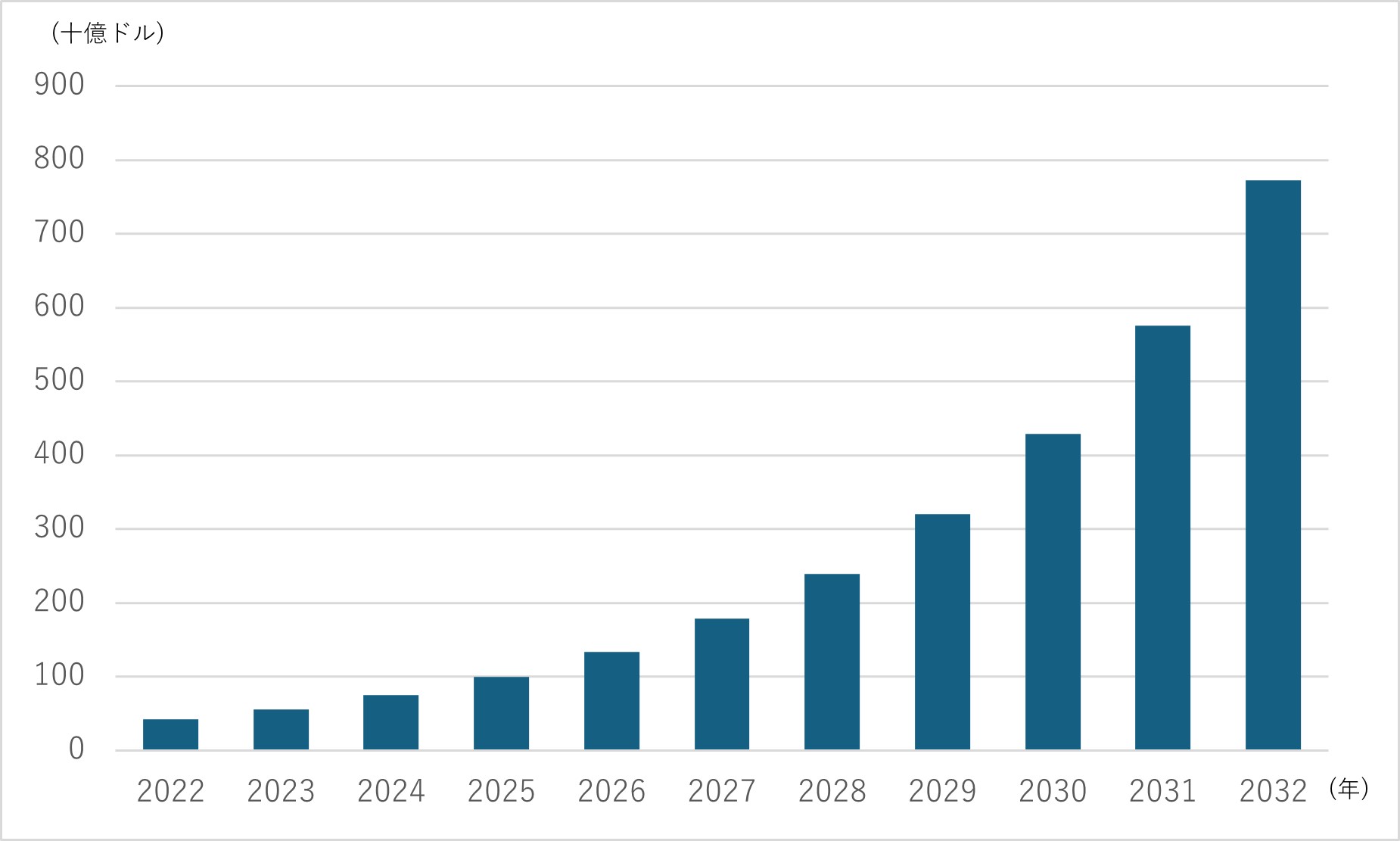

図7 GPU市場の見通し(2023年以降は予測値)

(出典)カナダPrecedence RESERCHの調査結果より筆者作成

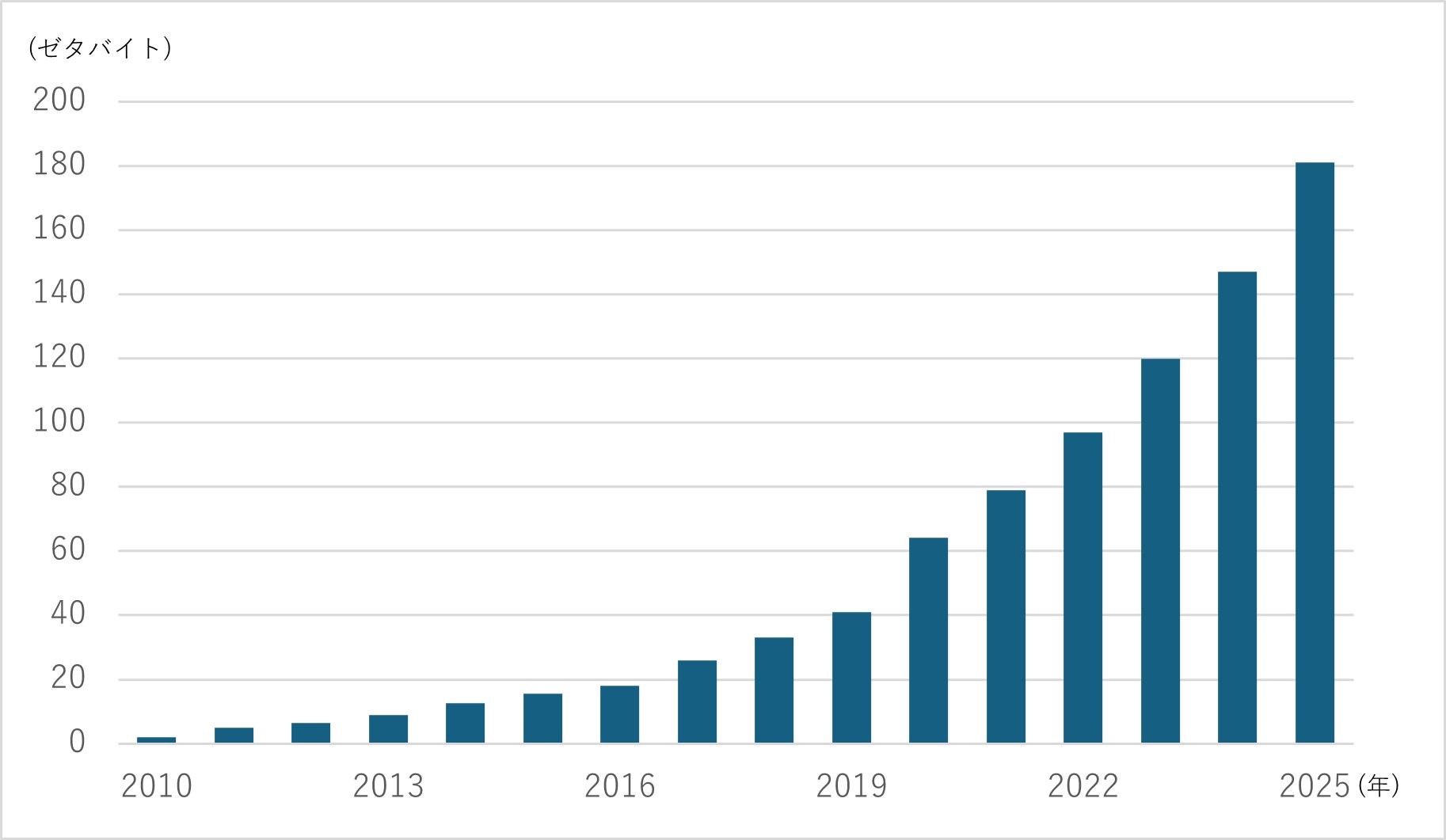

図8 世界のデータ流通量の推移(2021年以降は予測値)

(出典)ドイツStatistaの調査結果より筆者作成

①GPU市場は、カナダ調査会社Precedence RESERCH によると、2023年562億ドルから2032年7730億ドルへ年率33.8%での成長を予想。成長要因として、AI市場の成長、VRやAR、ゲーム市場の成長、IoT接続機器増加などが挙げられる。AI市場については、令和5年版情報通信白書で、2030年に2021年比約20倍の18,470億ドルに拡大するとの予測もあり、加速度的な成長が見込まれる。そのため、データセンターなどのハイパフォーマンスコンピューティング分野での先端GPU需要が高まっていると考えられる。

②AI市場拡大の背景の一つには、世界のデータ流通量の増加が考えられる。米Ciscoによると、世界のデータ流通量は、1984年から2017年にかけて70倍超に増加。今後についても2025年には、2022年比2倍になるとの予測もある。スマートフォンなどの普及、5Gなどの通信技術の発達、IoT接続機器増加などを背景に膨大なデータ量が利用されており、データセンター需要増加やビッグデータを活用したAI需要増加などにつながっている。

③AI用途の半導体の中心となっているのが、データセンター向けのGPUであり、このGPUを取り扱うメーカーは、NVIDIAやAMDなど数社のみ。その中で、NVIDIAは2023年時点で約8割のシェアを持つといわれる。

4 NVIDIAの企業分析

ここからは、NVIDIAがAIに使われるGPU市場において高いシェアを獲得し、また成長市場にも関わらずその地位を維持し続けている要因について解説する。NVIDIAのGPUの技術的な特徴や製品開発の歴史など、できる限り深い次元まで明らかにしたい。

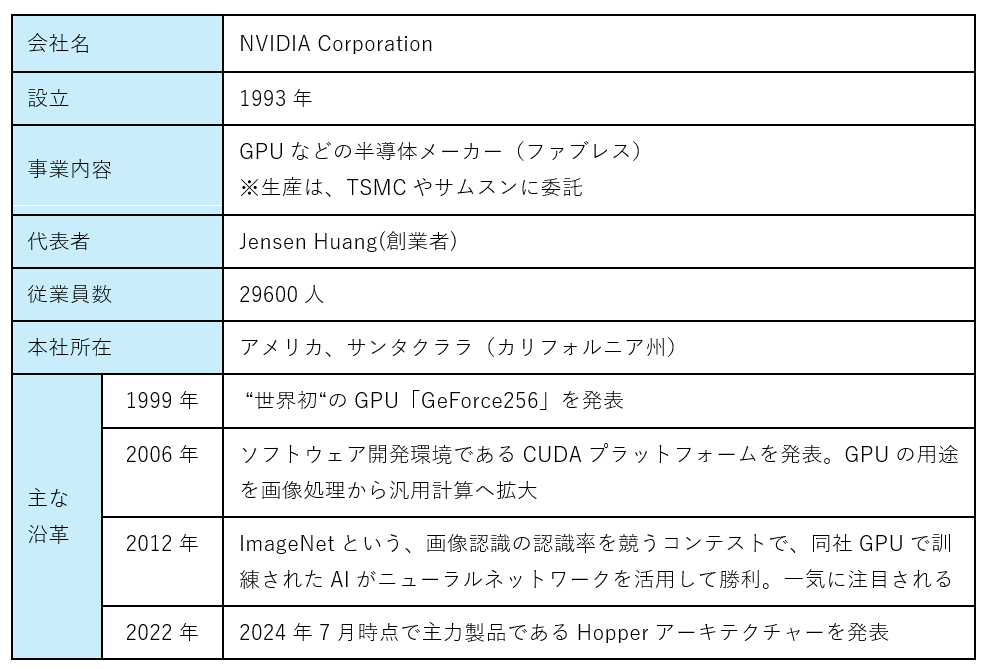

4-1 事業内容・沿革・経営者

表9 NVIDIAの企業概要(2024/7時点)

(出典)NVIDIAウェブサイトを基に筆者作成

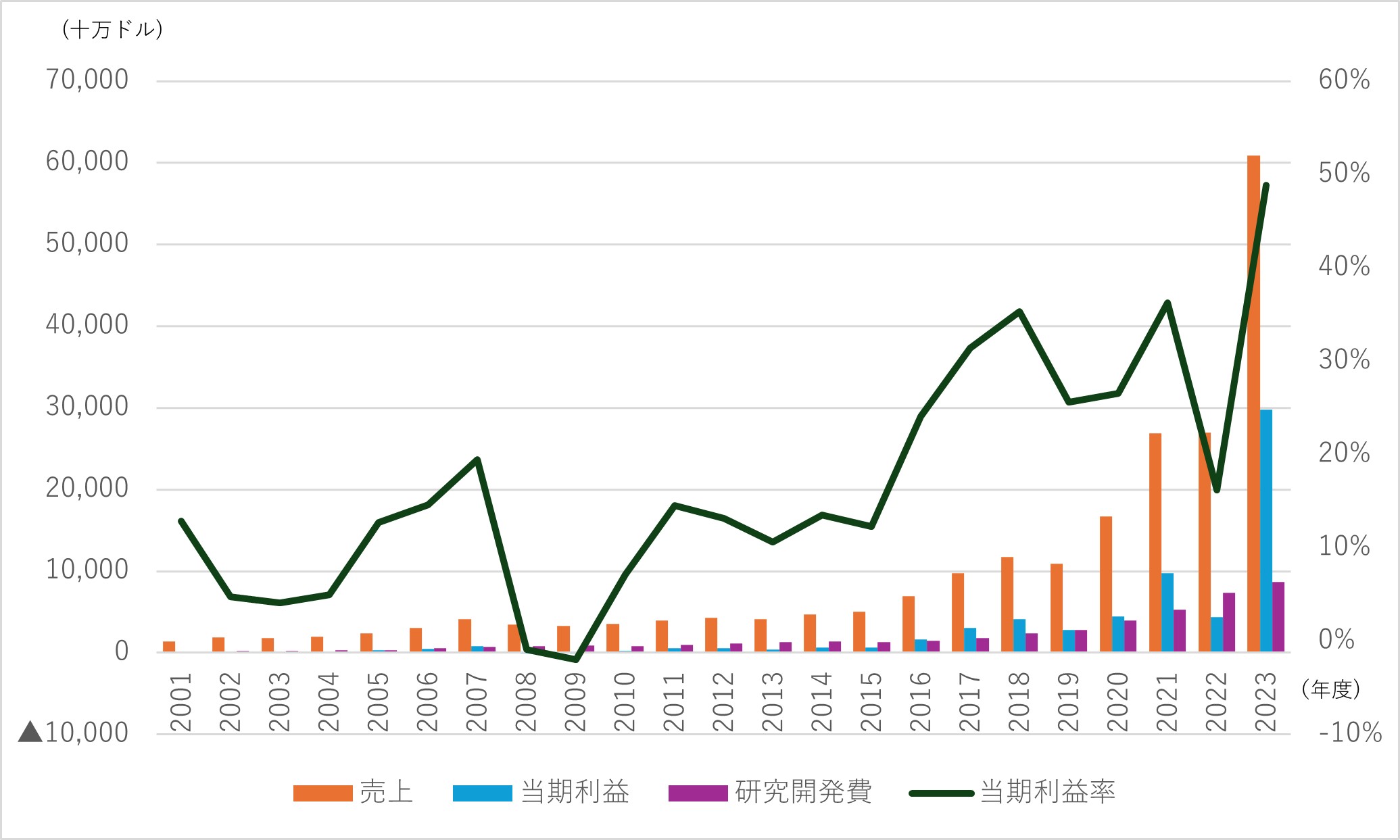

図9 財務諸表推移

(出典)米国証券取引委員会公開資料より筆者作成

①NVIDIAは、現経営者のJensen Huang氏が1993年に設立した半導体のファブレスメーカー。GPUの開発・設計に特化し、生産は台湾のTSMCなどに委託。設立当初はゲームなどコンピューターグラフィックス用の製品が中心であったが、2006年に汎用計算(統計処理、新薬研究など)に利用可能なソフトウェア開発環境CUDAを発表。2010年代に入り、本格的にAIなどの研究開発に取り組み、2010年代後半以降は、データセンター向け市場に進出し急成長。

②財務諸表の長期推移を見ると、2010年半ばまでは平均年率売上増加率10%程度と売り上げ成長が比較的緩やかだが、2016年ごろを境に成長速度が変化。2016年から2023年までの平均年率売上増加率は3割を超える。直近2023年(2024/1期)は、前年比2.3倍と急増しているが、増加分はほぼData Center部門。特にAI需要に伴うクラウド事業者(Googleなど)向けが急増している。

③データセンター向けGPU市場では、当社以外ではAMDやIntelも市場参入しているものの、NVIDIAが8割以上のシェアを有するとされる。

図10 NVIDIAの部門別売上割合

(出典)NVIDIA「2024 NVIDIA Corporation Annual Review」より筆者作成

④その他、財務諸表の長期推移からは、当期利益率が2016年ごろから上昇傾向にあり、直近2023年では50%近い数値となっていること、積極的に研究開発に投資し、過去23年間の対売上高比率が20%を超え、売上減少時も傾向として投資額を増やしていることが見て取れる。これらから、GPUの設計に特化した長期間にわたる継続かつ積極的な研究開発が、急成長するデータセンター向けGPU市場における独占的な地位、引いては高い収益性を生んだのではないかと推測される。(以下、次回〈10月4日〉に続く)

※「世界最先端の半導体会社NVIDIAの技術の強み(その2)」(2024年10月4日付)は以下のURLをご覧ください